Tóm tắt về Llama Stack: Công cụ Đa Nền Tương Thích Cho Phát Triển AI

Ngày 3 tháng 10 năm 2024, Meta đã công bố Llama Stack - một bộ các API mẫu giúp các phát triển viên dễ dàng hơn trong việc sử dụng mô hình Llama Language Model (LLM) của họ. Đây là nỗ lực của Meta nhằm chuẩn hóa quá trình kỹ thuật AI.

Giới thiệu về Llama Stack

Chủ tịch sản phẩm Chris Cox đã nhấn mạnh tại Facebook Connect 2024 rằng, với các phiên bản trước - Llama 1, 2 và 3 (bao gồm 3.1) - Meta tập trung rất nhiều vào việc cải thiện hiệu suất của mô hình, làm cho chúng trở nên thông minh nhất có thể, và mở rộng chúng cho người dùng cuối cùng. Với phiên bản mới này, Meta đã tập trung vào việc giải quyết các vấn đề mà phát triển viên phản ánh.

Llama Stack không chỉ đơn thuần là một bộ API, mà còn bao gồm nhiều thư viện PyTorch và môi trường phát triển khác để giúp bạn bắt đầu ngay lập tức. Cox mô tả nó như một tập hợp các "building blocks" - các thành phần cơ bản của một hệ thống LLM hiện đại được triển khai.

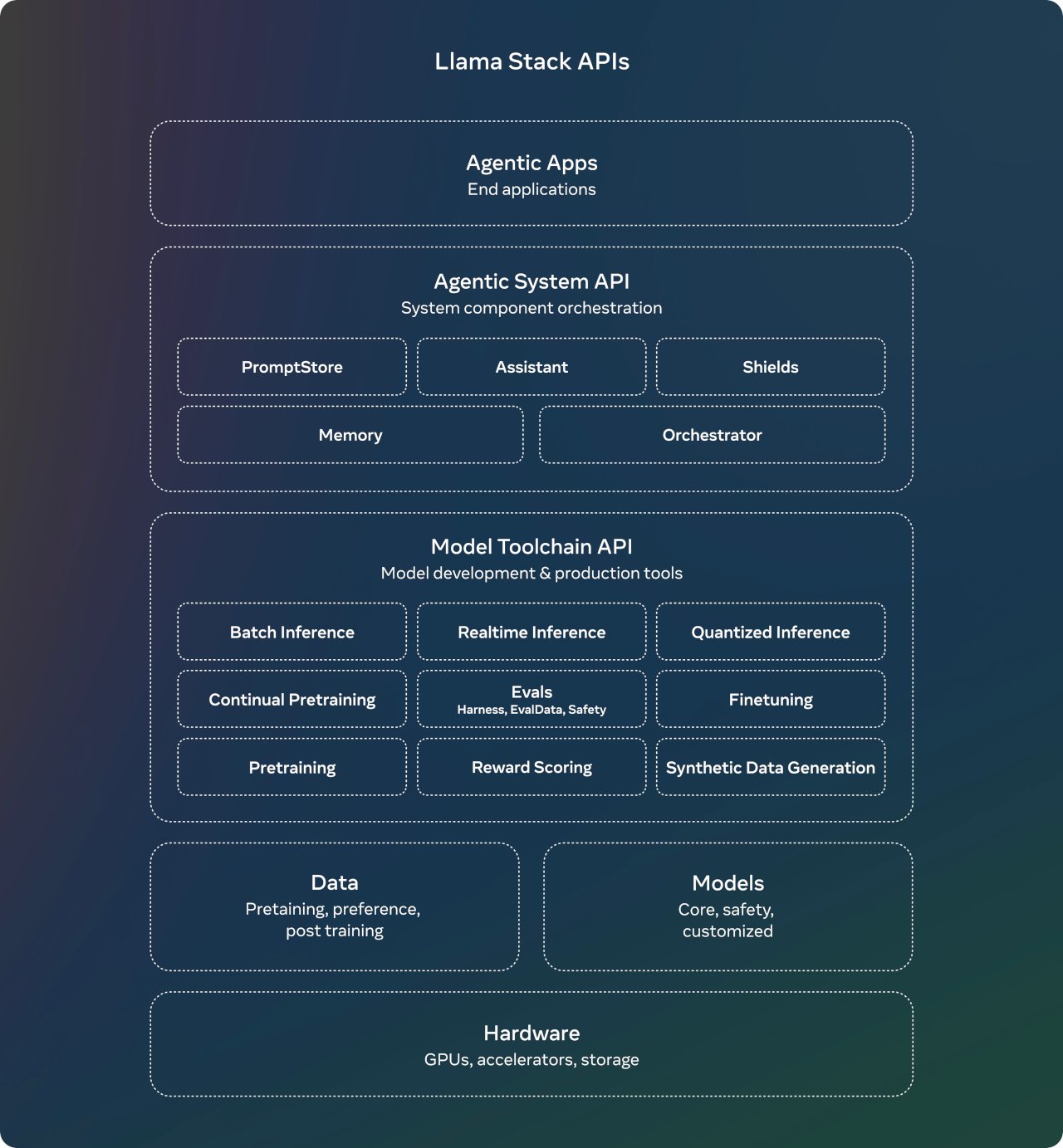

Các API Của Llama Stack

Llama Stack bao gồm một chuỗi các API "building blocks" mà phát triển viên có thể sử dụng để xây dựng ứng dụng dựa trên LLM, cụ thể là:

- Inference (Suy luận): API cho quá trình suy luận của mô hình.

- Safety (An toàn): API đảm bảo tính an toàn trong việc sử dụng mô hình.

- Memory (Nhớ): API quản lý bộ nhớ trong hệ thống LLM.

- Agentic System (Hệ Thống Tự Động): API cho quá trình tự động hóa.

- Evaluation (Đánh Giá): API để đánh giá hiệu suất của mô hình.

- Post Training (Sau Huấn Luyện): Các API liên quan đến việc huấn luyện sau này.

- Synthetic Data Generation (Tạo Dữ Liệu Hợp Tác): API cho việc tạo dữ liệu hợp tác.

- Reward Scoring (Điểm Khuyến khích): API để đánh giá thưởng.

Mỗi API này là một tập hợp các điểm kết nối REST, theo như được mô tả trong kho lưu trữ GitHub liên quan.

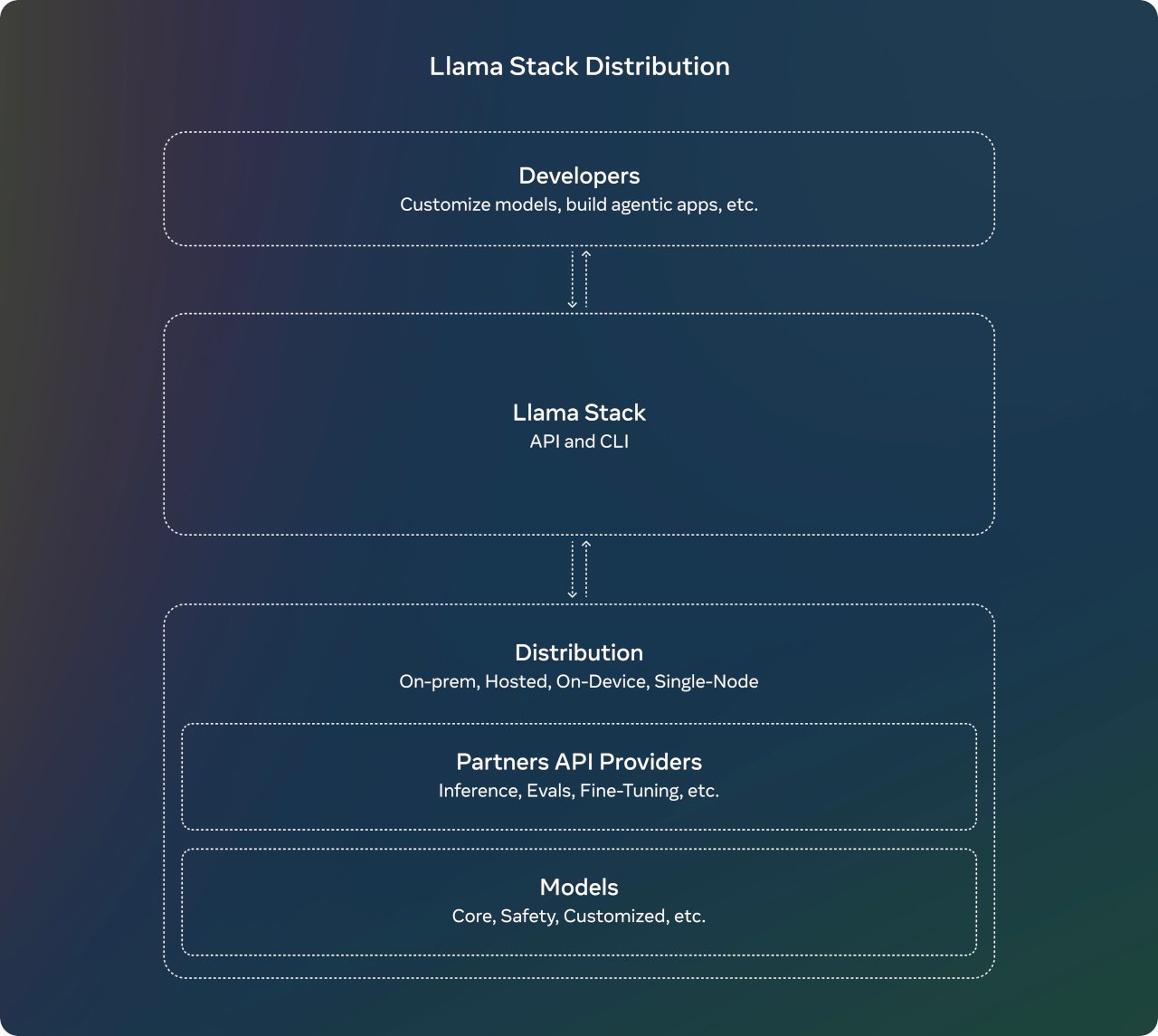

Phân phối Llama Stack

Meta đã tổ chức các "phân phối" để giúp phát triển viên dễ dàng hơn trong việc sử dụng các API. Hiện tại, có ba phân phối sẵn sàng trên Docker:

- Local GPU (GPU Vị Tích): Sử dụng GPU địa phương.

- Local CPU (CPU Vị Tích): Sử dụng CPU địa phương.

- Local TGI + Chroma (TGI + Chroma Vị Tích): Kết hợp TGI và Chroma.

Anh Ahmad Al-Dahle, người dẫn đầu AI tạo ra tại Meta, chia sẻ trên X rằng: "Phân phối Llama Stack của chúng tôi là bước tiến lớn trong việc hỗ trợ các phát triển viên với một điểm kết nối duy nhất. Chúng tôi đang chia sẻ với cộng đồng trải nghiệm đơn giản và thống nhất sẽ cho phép họ làm việc với mô hình Llama ở nhiều môi trường, bao gồm cả on-premises, cloud, single-node, và trên thiết bị."

Mục tiêu và Ý Nghĩa

Theo Prashant Ratanchandani, Phó Tổng Giám đốc kỹ thuật AI tại Meta, "Llama Stack là nỗ lực của chúng tôi nhằm định nghĩa và chuẩn hóa tất cả các thành phần để mang các ứng dụng AI đến người dùng. Việc làm điều này yêu cầu các phát triển viên phải suy nghĩ qua và chọn lựa nhiều thành phần, và LlamaStack giúp chúng tụ hợp lại trong một gói gọn - từ việc huấn luyện và fine-tuning mô hình, đến việc đánh giá và cuối cùng là xây dựng và triển khai ứng dụng."

Với việc công bố Llama Stack, Meta đang cung cấp cho cộng đồng phát triển viên một công cụ mạnh mẽ để tạo ra "apps agentic" - những ứng dụng có khả năng tự động hóa cao. Việc chuẩn hóa các API này sẽ giúp giảm bớt gian nan trong quá trình xây dựng và triển khai mô hình LLM, từ việc suy luận đến đánh giá hiệu suất.

Kết Luận

Llama Stack là một bước tiến quan trọng của Meta để hỗ trợ cộng đồng phát triển viên dễ dàng hơn trong việc sử dụng các mô hình AI. Nó không chỉ đơn thuần là một công cụ kỹ thuật mà còn là một giải pháp toàn diện cho quy trình phát triển ứng dụng dựa trên AI.